从概念到架构:一文彻底读懂HBM技术本质

从概念到架构:一文彻底读懂HBM技术本质

中国科学院半导体研究所 2025年06月13日 18:08 北京

文章来源:通信百科

原文作者:技术研究团队

本文主要讲述从概念到架构来了解HBM技术。

HBM的概念

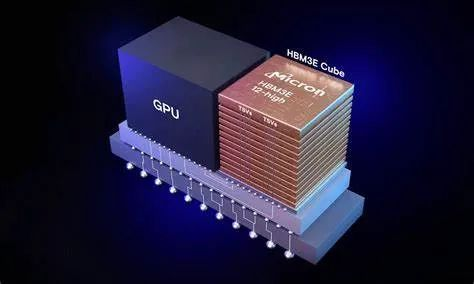

HBM(High Bandwidth Memory,高带宽内存)是一种能够实现高速、宽带宽数据传输的下一代DRAM技术和规范。其核心结构在于将多个DRAM芯片(通常4层、8层甚至12层)通过先进的封装技术垂直堆叠在一起。

正是由于HBM能以远超传统内存(如GDDR)的带宽(即数据传输速率)运行,因此它已成为高性能计算领域,特别是生成式AI所需GPU(图形处理器)的理想内存解决方案。

需要特别澄清的是,HBM与其说是一种新型DRAM芯片本身,不如说是一种定义了如何实现DRAM高速、宽带宽互连的物理和电气“接口规范”。通常,我们将基于此规范制造出来的堆叠式DRAM芯片组及其相关接口技术统称为“HBM”。

为何HBM被选用于AI GPU?

HBM对于AI应用至关重要,根本原因在于它能够支撑GPU以“高带宽、低延迟”的方式高效处理海量数据流。要深入理解其重要性,我们需要按顺序剖析三个核心概念:“GPU”、“带宽”、“VRAM”。

GPU是什么:与CPU的区别

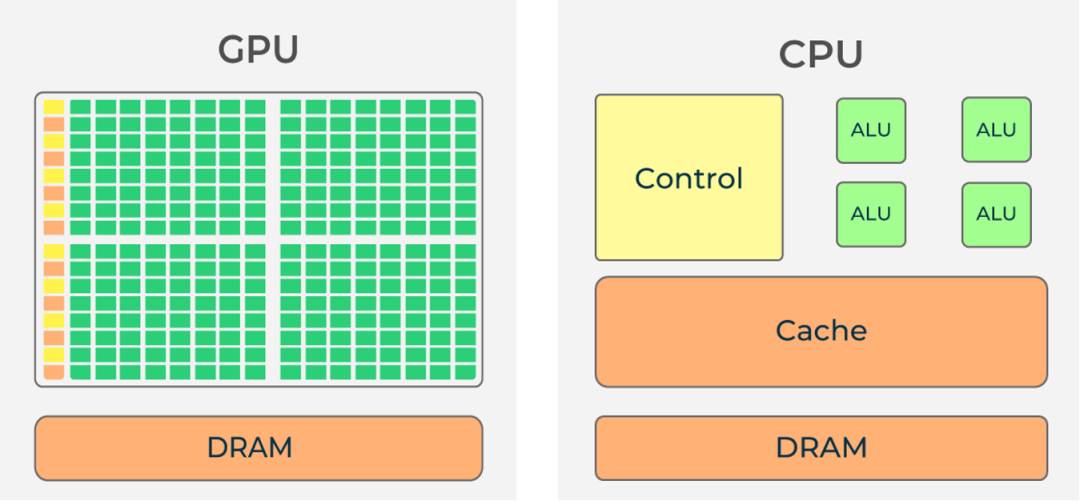

GPU是“图形处理器(Graphic Processing Unit)”的简称,最初设计用于处理图像渲染和视频编码等任务,是一种高度并行的专用处理器(运算单元)。

其架构特点在于拥有数量庞大的计算核心(常达数千甚至上万核心,如NVIDIA H100拥有18432个CUDA核心),专门用于同时(并行)处理海量数据(如像素或AI计算中的矩阵元素)。

众所周知,CPU(中央处理器)是个人电脑和服务器中执行通用计算任务的核心。CPU通常拥有几个到十几个高性能核心(核心:CPU或GPU中实际执行算术逻辑运算的单元)。

由于每个CPU核心都具备强大的单线程性能和复杂的控制逻辑,因此它非常适合执行需要按顺序处理、逻辑复杂的计算和指令。然而,CPU核心数量相对有限,且通常一个核心一次只能高效处理一个主要线程,所以不太擅长同时处理大量简单但并行的任务。

与此形成鲜明对比的是,GPU则拥有数百至数千个(现代高端GPU可达数万个)相对精简但高度优化的核心,其设计精髓就在于同时(并行)处理海量的、相对简单的计算任务。

正是这种大规模并行架构的特性使其成为处理数据量极其庞大、计算模式相对规则的AI训练和推理的完美匹配,因此被广泛用作AI加速的核心芯片。

为什么需要HBM?

内存带宽的定义

首先,我们来了解什么是内存带宽?

内存带宽,简称带宽,memory bandwidth,指的是“单位时间内(通常以秒计)内存子系统能够传输的数据总量”。它直接衡量了处理器(如CPU或GPU)能够以多快的速度从与其相连的半导体内存(如DRAM)中读取数据或将计算结果写入内存。

更具体地说,如果某一内存系统一秒钟可以稳定传输100GB的数据,那么我们就称该内存的带宽为100GB/s。

带宽的数值大致可以用以下公式表示和估算:

内存带宽(GB/s) = [ 总线位宽(bit) × 有效传输速率(GT/s) ] ÷ 8

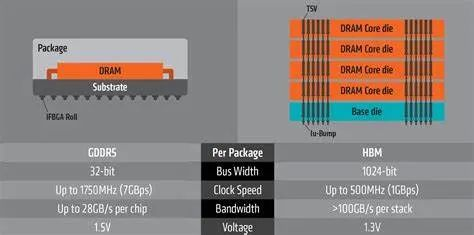

总线位宽 (位宽, bit):内存接口一次能并行传输多少位(bit)的数据,这决定了数据通道的“宽度”。位宽越宽,单位时间能并排通过的“数据车道”就越多。例如,HBM2E的接口位宽可达1024位甚至更高,远超GDDR6的32位。

有效传输频率 (Hz / GT/s):每秒能进行数据传输操作的次数。现代高速内存(如GDDR, HBM)通常使用双倍数据速率(DDR)或四倍数据速率(QDR)技术,在时钟信号的上升沿和下降沿都传输数据,有效频率往往是物理时钟频率的倍数(例如GDDR6的物理时钟可能为14-16GHz,有效传输速率可达16-22 GT/s)。

每时钟周期传输次数:取决于接口技术。例如:DDR SDRAM是2次/时钟(上升沿和下降沿各一次),而更先进的接口可能支持更多。

÷ 8:是将比特(bit)转换为字节(Byte)。1 字节(Byte)= 8 比特(bit),带宽标准单位是 GB/s(十亿字节/秒)。

由此可见,要获得更高的内存带宽,关键在于让数据传输既“跑得快”(高的有效传输频率),又“车道宽”(宽的总线位宽)。带宽的瓶颈往往受限于两者中最弱的环节。

在AI应用中,模型参数量巨大(可达数百GB甚至TB),计算过程中需要频繁地在GPU核心和内存之间交换海量参数和中间结果(激活值、梯度等)。为了确保GPU强大的计算能力不被数据供给拖累(即避免“喂不饱”GPU),“高带宽”的内存子系统就成为刚性需求。

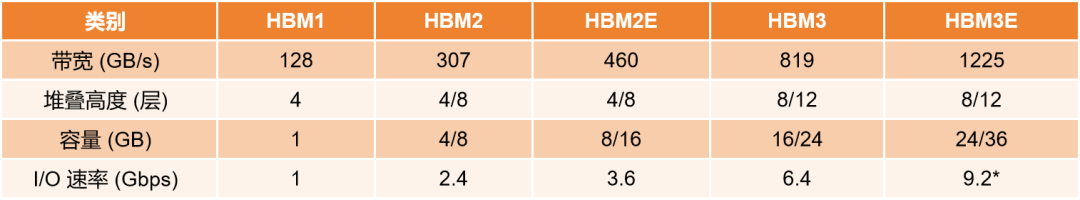

HBM正是通过革命性地大幅增加总线位宽,即增加并行传输线路的数量,可达1024位甚至2048位),结合高速接口技术,才得以实现远超传统方案(如GDDR)的极高内存带宽(例如HBM3E可达1225GB/s以上)。

VRAM的作用

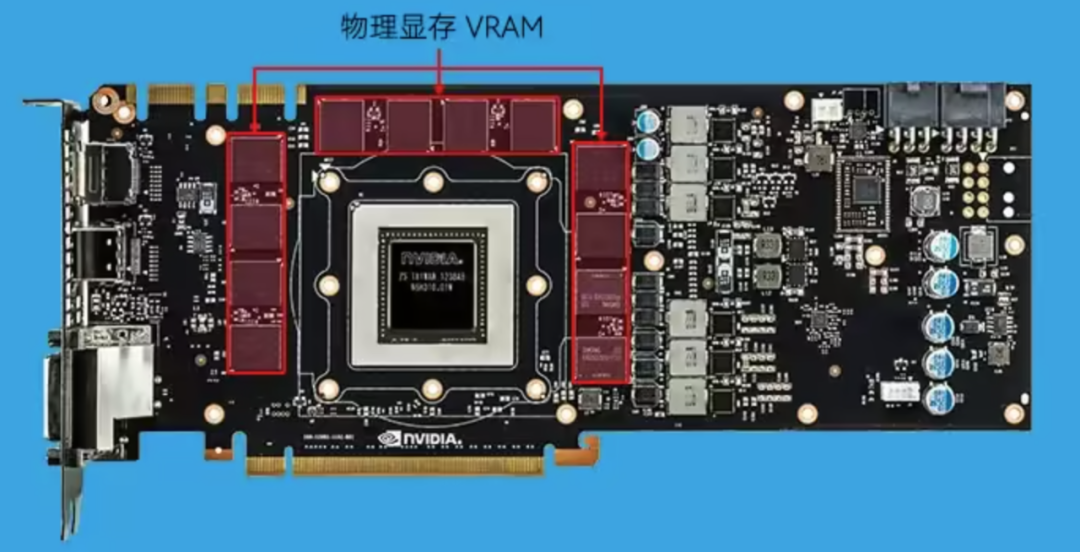

专为GPU设计的高速内存被称为VRAM(视频随机存储器,Video RAM),而当前在高端AI和计算领域占据主流地位的就是HBM。一张典型的显卡(或AI加速卡)的核心组件就是GPU芯片和与其紧密相连的VRAM模块(通常由多颗HBM堆栈组成)。

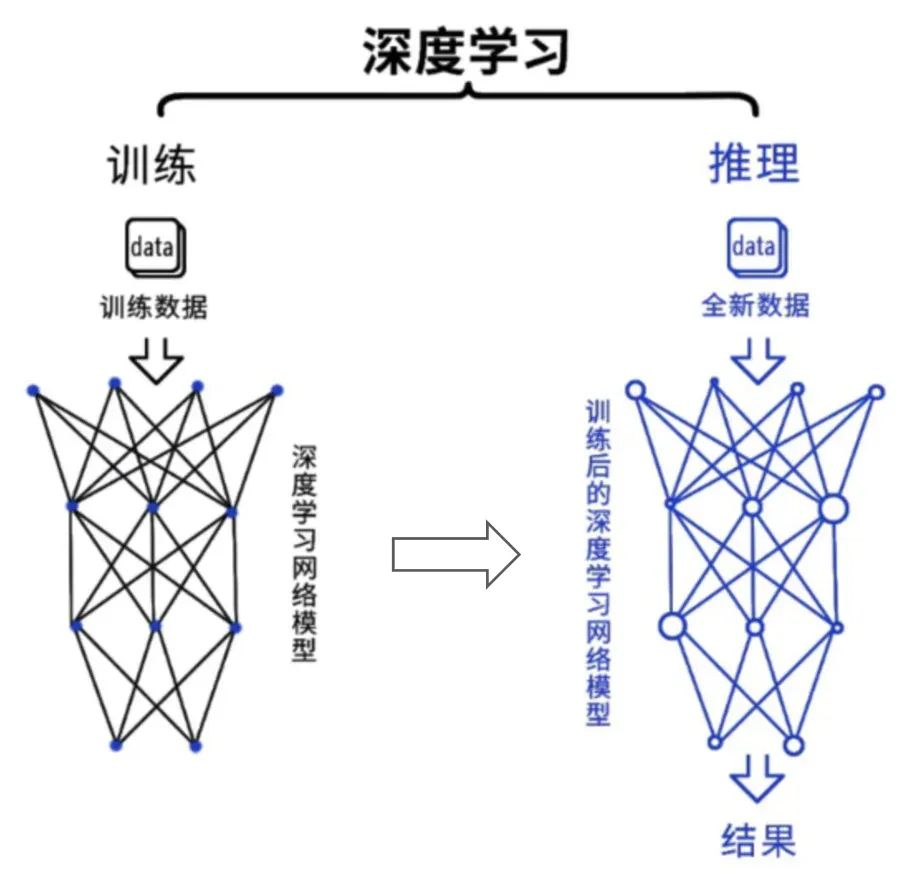

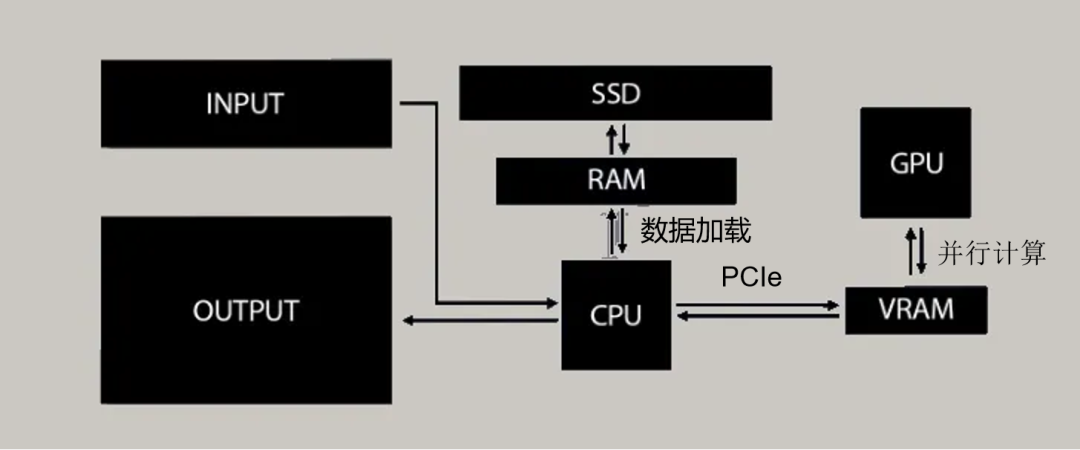

以下是GPU执行计算任务时典型的数据流:

1. 数据加载: 将计算所需的初始数据(输入数据)从较慢但容量更大的CPU系统内存(RAM)通过PCIe等接口传输到GPU专用的高速VRAM(HBM)中。

2. 并行计算: GPU的众多计算核心从高速的VRAM(HBM)中读取所需的数据片段,执行密集的并行计算(如矩阵乘法、卷积)。

3. 结果暂存: 计算产生的中间结果或最终结果被快速写回到VRAM(HBM)中暂存。

4. 数据输出/保存: 处理完成的数据最终从VRAM(HBM)传输回CPU系统内存(RAM)进行后续处理或存储,或者在某些情况下(如图形输出)直接从VRAM输出到显示接口。

在图像识别、自然语言处理(NLP)、大语言模型(LLM)训练/推理等AI任务中,模型包含数十亿甚至万亿参数,计算过程会产生海量的中间激活值和梯度数据。整个计算过程高度依赖在GPU核心和VRAM之间进行持续不断的高速数据交换。

因此,VRAM的性能,特别是其“高速读写海量数据”的能力,直接决定了GPU整体计算效率的上限。

虽然GPU依靠其海量的并行计算单元(核心)来加速处理,但如果这些核心急需的数据(指令、参数、中间结果)因为内存带宽不足或延迟过高而未能及时送达,计算单元就会陷入“饥饿”等待状态(Stall),导致宝贵的算力被白白浪费,整体性能无法发挥(形成“内存墙”或内存瓶颈)。

正因如此,对于追求极致性能的AI专用GPU(如NVIDIA H100, AMD MI300X等),HBM凭借其卓越的“高带宽”(满足数据吞吐需求)和“低延迟”(减少核心等待时间)特性,成为无可替代的内存解决方案。

HBM的结构

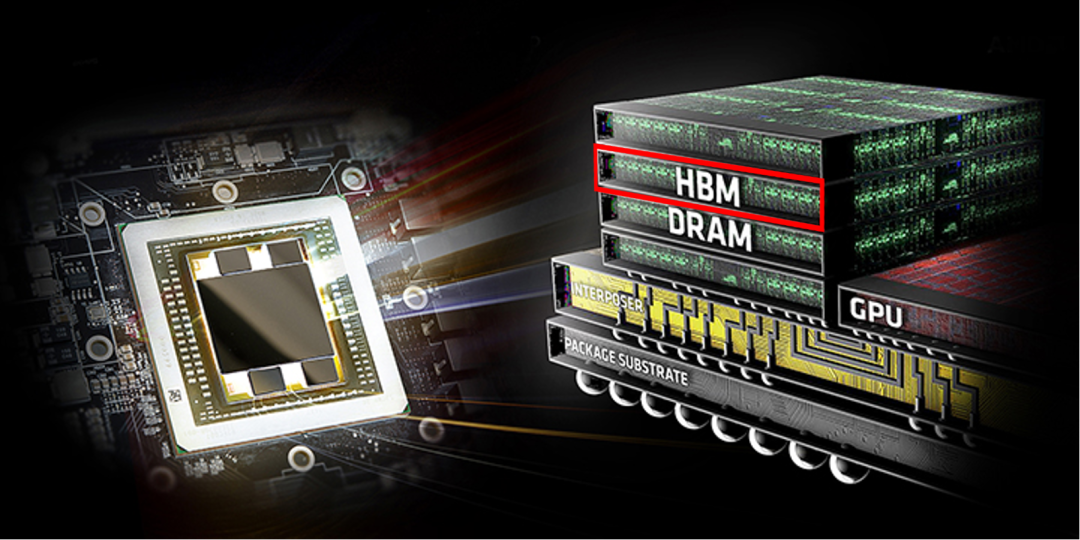

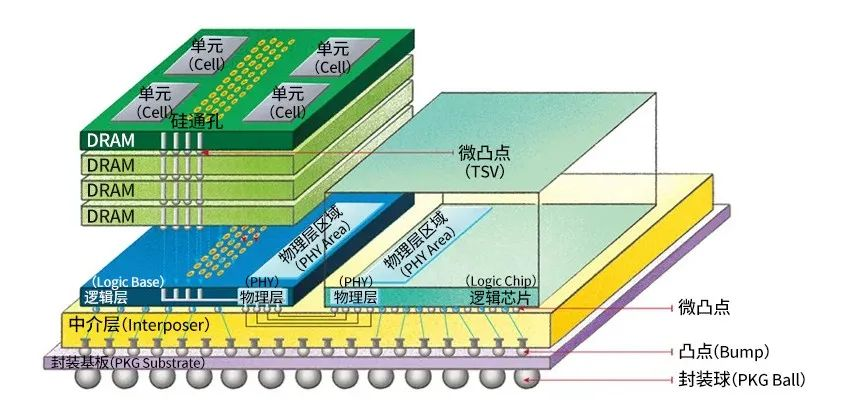

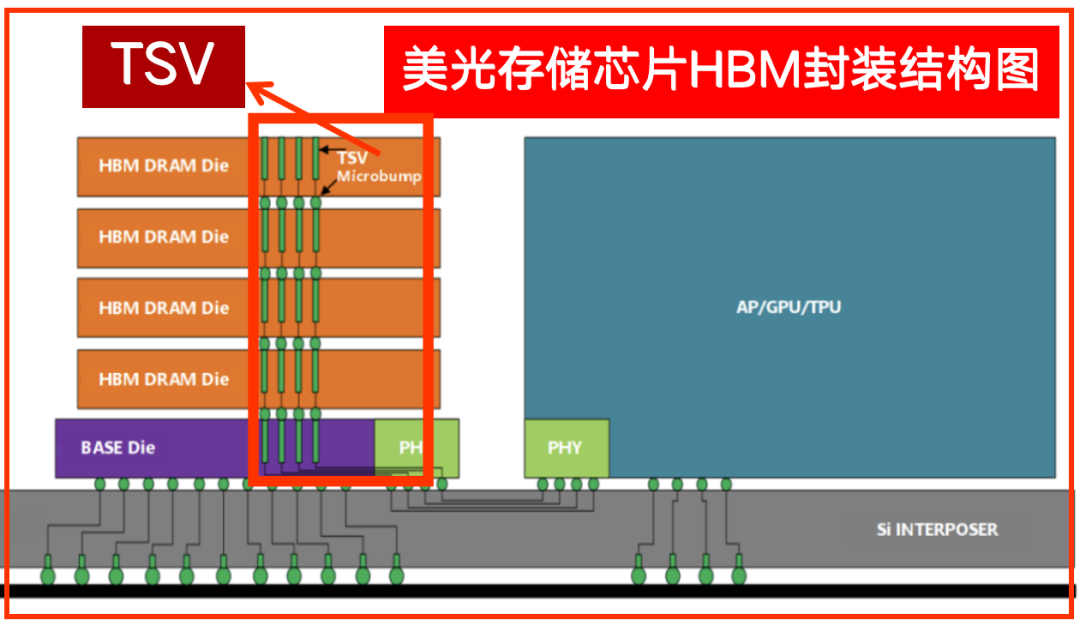

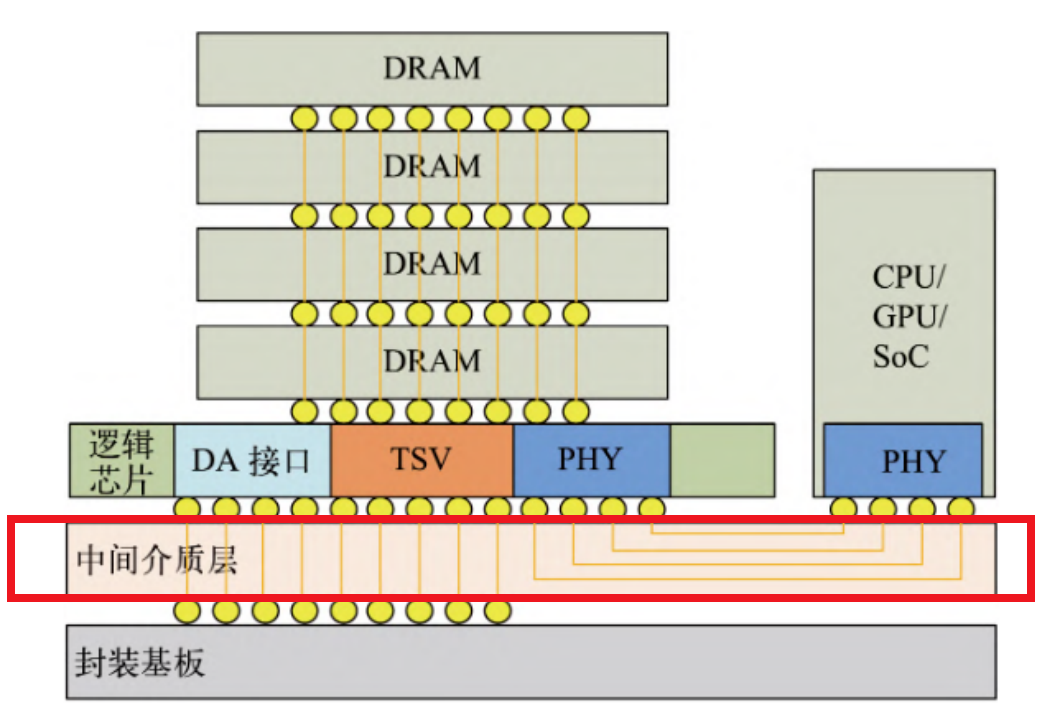

HBM的核心创新在于其独特的“3D堆叠封装”结构:HBM摒弃了传统内存芯片平铺的方式,它将多颗标准DRAM芯片(称为DRAM Die)像高楼一样垂直堆叠(3D Stacking)起来,并通过密集的硅通孔(TSV: Through-Silicon Via) 在垂直方向上将它们电学互连。

同时,每颗DRAM芯片通过极薄的粘合材料粘合,并通过微凸块(Microbumps)实现层间初步互连。

理解HBM高性能的关键在于以下三个相互协作的核心技术要素:

堆叠 (Stack):垂直堆叠多层DRAM芯片,在单位面积上实现了存储容量的指数级增长(如8层堆叠提供8倍于单颗芯片的容量),实现了空间节省与大容量化。

TSV (硅通孔):在堆叠的DRAM芯片内部钻孔并填充导电材料形成垂直通道(直径仅5-10微米),以此高密度、短距离的垂直布线直接连接上下层芯片的信号、电源和地线,从而实现了传统平面布线无法企及的极宽总线位宽(1024位以上)。

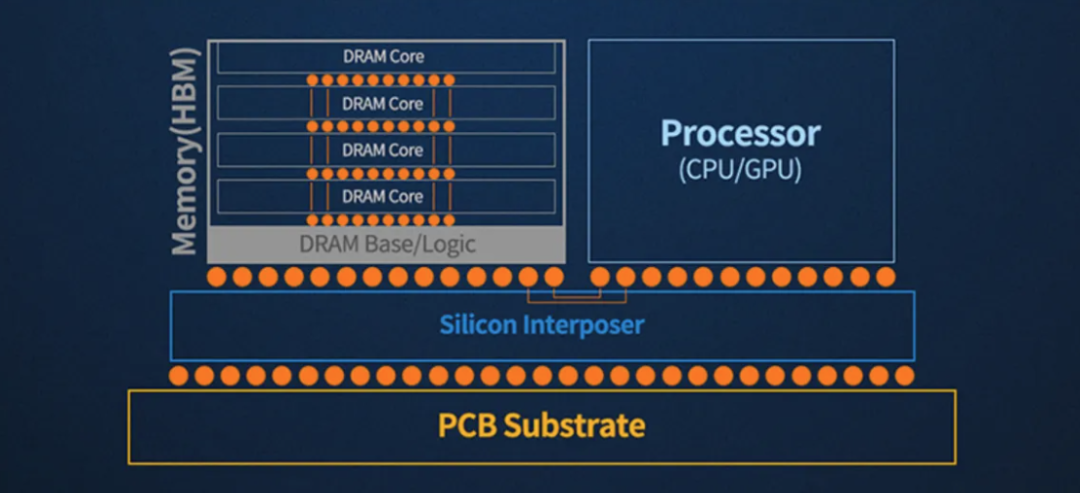

中间介质层 (Interposer):一块承载GPU芯片和HBM堆栈的精密硅基板或有机基板。 它利用其表面和内部的高密度布线(线宽/线距可达微米级),将HBM堆栈的超宽接口与GPU芯片的高速I/O端口在极短距离内互连。

下图清晰地展示了传统GDDR与革命性HBM在结构布局上的根本差异:

GDDR (平面离散式)

多个独立的DRAM芯片(颗粒)以BGA封装形式平面式地排列安装在GPU芯片周围的PCB基板上。

缺点:每个DRAM颗粒都需要独立的、相对较长的PCB走线连接到GPU。这不仅大量占用宝贵的PCB面积,增加了板卡尺寸和成本,而且长走线引入了显著的信号传输延迟(Latency)、信号完整性(SI)挑战(如反射、串扰)和更高的驱动功耗。总线位宽受限于可布线的物理通道数量(通常最多256位或384位)。

HBM (3D堆叠 + 2.5D集成)

将预先垂直堆叠封装好的HBM模块(包含多颗DRAM芯片)与GPU芯片并排紧邻地放置在同一块高密度中介层(Interposer)基板上。

优点:堆叠结构本身极大地节省了平面空间(Z轴利用);与GPU的近邻布局(同中介层) 使得互连布线长度极短(毫米级甚至更短)。

这共同实现了:

超高空间利用率

超大存储容量

超宽总线位宽(通过TSV和中介层实现)

超低信号延迟

卓越的信号完整性

显著降低的通信功耗

综上所述,HBM通过DRAM的3D堆叠封装和与GPU在2.5D中介层上的近端集成布局,完美克服了传统GDDR的物理限制,从而实现了数量级提升的带宽和革命性的功耗效率。

在HBM堆叠结构中,上下层DRAM芯片之间最关键的垂直互连是通过“TSV(Through Silicon Via:硅通孔)”技术实现的。TSV是在硅芯片(Die)上蚀刻出微小的通孔(直径通常5-50微米),然后填充以铜等导电材料形成的垂直电气通道。

TSV技术的价值

极短互连: 它允许信号、电源和地线直接在垂直方向上穿透硅芯片,在相邻的DRAM芯片层之间建立最短可能的电气连接路径(仅芯片厚度,约50-100微米),完全绕过了传统需要绕行芯片边缘的长导线焊接(Wire Bond)或倒装焊(Flip Chip)互连方式。

高密度互连: 成千上万甚至数十万个TSV可以密集地分布在芯片内部,提供了远超平面封装方式的互连密度和并行通道数量,这是实现超宽总线位宽(如1024位、2048位)的基础。

高速低耗: 极短的垂直连接路径大幅降低了信号传输延迟(Latency),减少了信号衰减和失真,同时显著降低了驱动这些互连所需的功耗。

因此,与传统的、将DRAM芯片平面排列并通过封装引线或PCB走线进行较长距离互连的方式相比,HBM采用的TSV垂直互连使信号在堆叠芯片间的传输速度更快、效率更高、功耗更低。

这种革命性的垂直互连结构,是HBM能够同时实现高存储密度(容量)、超高带宽和低功耗运行的基石。

中介层的作用

HBM堆栈与GPU芯片之间并非直接焊接在普通PCB上,而是共同集成在一块称为中介层(Interposer) 的精密中间基板上。

中介层本质上是一块具有超精细布线能力(线宽/间距可达1微米或更小)的被动硅基板(Silicon Interposer)或先进有机基板。

中介层在HBM系统中扮演着至关重要的角色:

承载平台: 它为GPU裸片(Die)和HBM堆栈裸片提供了物理安装平台。

超高密度互连: 其核心价值在于其表面和内部可以制造出数量极其庞大(数千至数万条)、间距极窄(微米级)的金属布线(Redistribution Layer - RDL)。这些布线如同高架桥或密集的高速公路网。

连接桥梁: 它利用这些超密集布线,将HBM堆栈底部的超宽接口(焊球阵列,通常包含数千个触点)与GPU芯片边缘的海量高速I/O端口(微凸块阵列)在极短的距离(几毫米到十几毫米)内精确地、低损耗地连接起来。

再次强调,HBM获得超高带宽的关键途径并非单纯提升数据传输的“单车道速度”(时钟频率),而是通过TSV和中介层共同创造了数量惊人的“并行数据车道”(即超宽总线位宽),实现“一次传输巨量数据”。

HBM的演进与挑战

自第一代HBM问世以来,这项技术已迭代至第六代,涵盖HBM2、HBM2E、HBM3、HBM3E及规划中的HBM4。随着2025年HBM3E量产竞争进入白热化,下一代HBM4的角逐序幕已然拉开。

在技术持续升级的进程中,封装技术逐渐成为竞争焦点。尤其是散热瓶颈日益凸显。若无法有效控制堆叠芯片产生的积热,将直接导致性能衰减、寿命缩短及功能异常,这使得散热能力与容量、带宽共同构成先进存储开发的三大核心指标。

作为HBM高速化的基石,TSV(硅通孔)技术通过在DRAM芯片钻刻数千微孔构建垂直电极通道,如同为HBM这座"摩天大楼"架设了贯通楼层的"高速电梯"。然而当堆叠层数跃升至12层的HBM3E时,散热压力与翘曲问题形成双重枷锁:在总厚度不变约束下,DRAM芯片需比8层HBM3减薄40%,薄化工艺引发的结构形变成为新的技术障碍。

要突破12层以上堆叠的物理极限,混合键合技术或将成为必然选择。该方案虽能实现微米级3D互联,但预计导致封装成本激增30%以上。

尽管HBM在AI计算领域具有不可替代性,高昂成本仍是普及壁垒,未来行业可能探索两条破局路径:一方面开发精简版"HBM-Lite"以优化成本,另一方面在系统级整合HBM与DDR5/GDDR7构建混合存储架构,由HBM处理热数据而传统内存承载冷数据。这种分层策略可针对性满足场景需求,例如高端AI训练采用全HBM架构保障吞吐,边缘推理则通过混合方案平衡TCO(总拥有成本)。

END